Kunstig intelligens har fascinert oss i lang tid med sin evne til å etterligne menneskelig intelligens og utføre komplekse oppgaver. Men hvor startet denne reisen? I dette innlegget vil vi se på kunstig intelligens med historiske briller.

Før vi begynner, hva er egentlig kunstig intelligens? Kunstig intelligens (KI), eller Artificial Intelligence (AI), defineres som systemer som «utfører handlinger, fysisk eller digitalt, basert på tolkning og behandling av strukturerte eller ustrukturerte data, i den hensikt å oppnå et gitt mål.» (regjeringen.no)

1950-tallet:

Når det gjelder starten av historien til KI så må vi faktisk helt tilbake til 1950- tallet. På en seks uker lang konferanse på Dartmouth College i USA i 1956 ble begynnelsen av KI markert, da forskere begynte å utforske ideen som kunne tenke og løse problemer som mennesker. Konferansen ble kalt "Summer Research Project on Artificial Intelligence". Mange av de som skulle forme fagfeltet de neste tiårene var tilstede. John McCarthy (1927-2011) var sentral i etableringen av begrepet AI, og han var også en foredragsholderne på konferansen.

1970-tallet:

Etter konferansen i 1956 var det høye forventninger til et gjennombrudd med maskiner som er smartere enn mennesker. Det ble donert mye penger til forskning på AI. På 1970- tallet uteble resultatene sammenlignet med forventningene. Både donering av penger og forskningen stoppet derfor opp. De store fremskrittene ble lagt i dvale og 1970-tallet kalles derfor den første AI - vinteren.

1980 - 1990-tallet:

KI møtte mye motstand og det var vanskelig å oppnå forventede resultater. Likevel fortsatte forskningen innen nevrale nettverk og maskinlæring, samt at nye tilnærminger ble utforsket. 1997 var en viktig milepæl i AI historien, da AI-systemet Deep Blue (utviklet av IBM) vant over datidens regjerende verdensmester i sjakk, Gary Kasparov. (https://www.tableau.com/data-insights/ai/history)

Les mer: twoday AI Agent - en ny superkraft i din virksomhet

2000-tallet:

Med fremveksten av Internett og digitale plattformer ble store mengder data tilgjengelige. Maskinlæringsteknikker, spesielt dyp læring, ble stadig mer effektive. Algoritmer kunne nå trene på enorme datasett og oppnå imponerende resultater innen bildegjenkjenning, naturlig språkbehandling og mer.

2012:

Alex Krizhevsky var sentral for å skyte fart i utviklingen av kunstig intelligens. Bildegjenkjenning med nevrale nettverk hadde mye høyere treffsikkerhet enn tidligere, og det viste seg at metoden kunne overføres til tolkning av lyd og tekst.

2021-2022:

Et team hos Google, kalt DeepMind, brukte framgangsmåten Deep Reinforcement Learning for å lage AlphaFold. AlphaFold er en maskinlæringsmodell som modellerer 3D-struktur for proteiner. Denne maskinlæringsmodellen har vært banebrytende, da den kunne løse en av de største utfordringene innen biologi, og har akselerert innovasjonstakten innenfor bioteknologi og medisinsk forskning.

Det var flere store ting som skjedde i AI sin historie i 2021. "Tekst-til-bilde" revolusjonen begynte med DALL-E (OpenAI). Dette er en modell som lar deg skrive inn en tekst, der du beskriver hva du ønsker å få produsert et bilde av. Det har også kommet flere varianter etter dette. Viktige modeller å trekke frem er Stable Diffusion (Stability AI, 2022), som er en Open Source variant, og Midjourney (Midjourney Inc., 2022). Sistnevnte har kanskje de fleste hørt gjennom et søksmål grunnet en del juridisk konflikt rundt opphavsrett, og om denne er brutt når man har trent disse modellene og eksisterende bilder.

I 2022 kom som kjent ChatGPT fra OpenAI. Dette er den første chatboten som faktisk oppførte seg slik man hadde håpt og ønsket at en chatbot skulle gjøre, og dette var sannsynligvis en stor grunn til at det tok av så raskt som det gjorde. En konsekvens av lanseringen av ChatGPT er at de fleste bedrifter nå har AI høyt oppe på sin prioriteringsliste, i mye større grad enn tidligere. Bruken av ChatGPT har vært ekstremt raskt voksende. Etter kun 5 måneder, passerte ChatGPT 1 milliard brukere. Til sammenligning har ChatGPT like mange brukere etter fem måneder, som det tok Facebook 8 år å oppnå.

Les mer: Hvordan bli en mer effektiv utvikler med ChatGPT?

Hva er en Generative Pre-Trained Transformer (GPT)?

Som navnet tilsier er GPT en modell som genererer noe. Den er forhåndstrent, som betyr at det finnes parametere for modellen som allerede er predefinert. Den baserer seg på en transformer-arkitektur.

Så hvordan fungerer GPT, som er grunnstenen i ChatGPT? Det er første og fremst en tekstprediktor. La oss eksempelvis se på når du skriver noe på telefonen din, som en melding. Da vil stavekontroll-verktøyet forsøke å forutse det neste ordet som du skal skrive. Denne modellen tar kun utgangspunkt i det siste eller de siste ordene, og har dermed veldig lite minne.

GPT er en språkmodell, som i utgangspunktet tar inn en mengde tekst og forsøker å forutsi hva det neste ordet skal være. Problemet med hukommelse, slik som med stavekontroll-verktøyet ditt på telefonen, er løst gjennom en transform-arkitektur. Den tillater modellen å trene på veldig store datasett, og ikke bare løse èn spesifikk oppgave, men ulike oppgaver basert på kontekst.

I dag - KI har allerede blitt en naturlig del av (arbeids)hverdagen

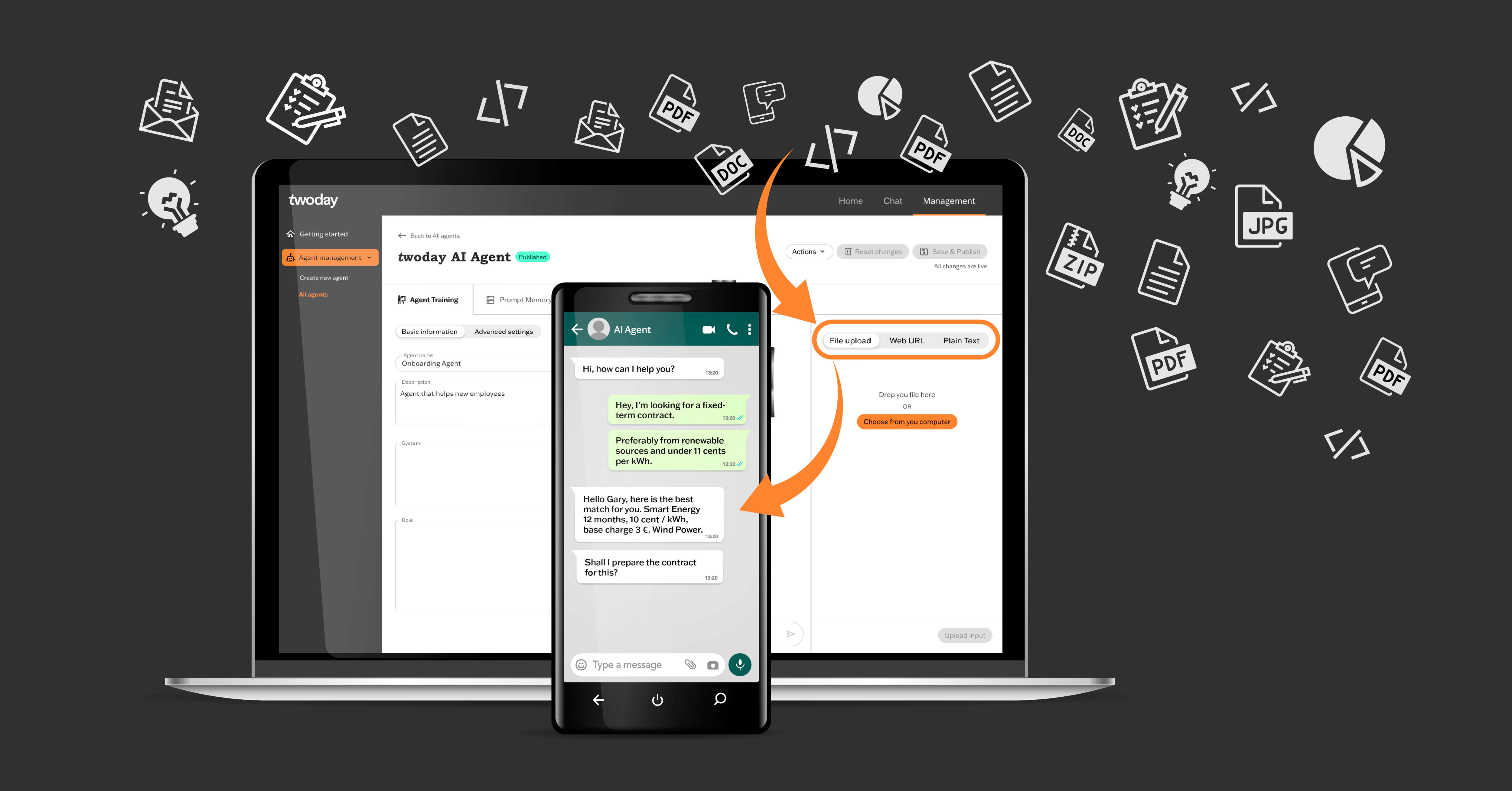

I dagens tid er kunstig intelligens rundt oss overalt. Taleassistenter, automatiserte biler, anbefalingssystemer og mer er nå en realitet. KI fortsetter å utvikle seg raskt, drevet av avanserte datamaskiner, avanserte algoritmer og en dypere forståelse av hvordan menneskelig intelligens fungerer. Fremtiden vil bringe nye utfordringer og muligheter mens KI fortsetter å forme vår verden. Vi tror at i tiden fremover så blir kunstig intelligens også en større del av hverdagsproduktene som man bruker i jobbsammenheng. Vi har laget nettopp et slikt produkt; twoday AI Agent. Denne kan du lese mer om her.

Ta kontakt med oss!

Er det noe du lurer på kan du legge igjen kontaktinformasjon så tar vi kontakt med deg.